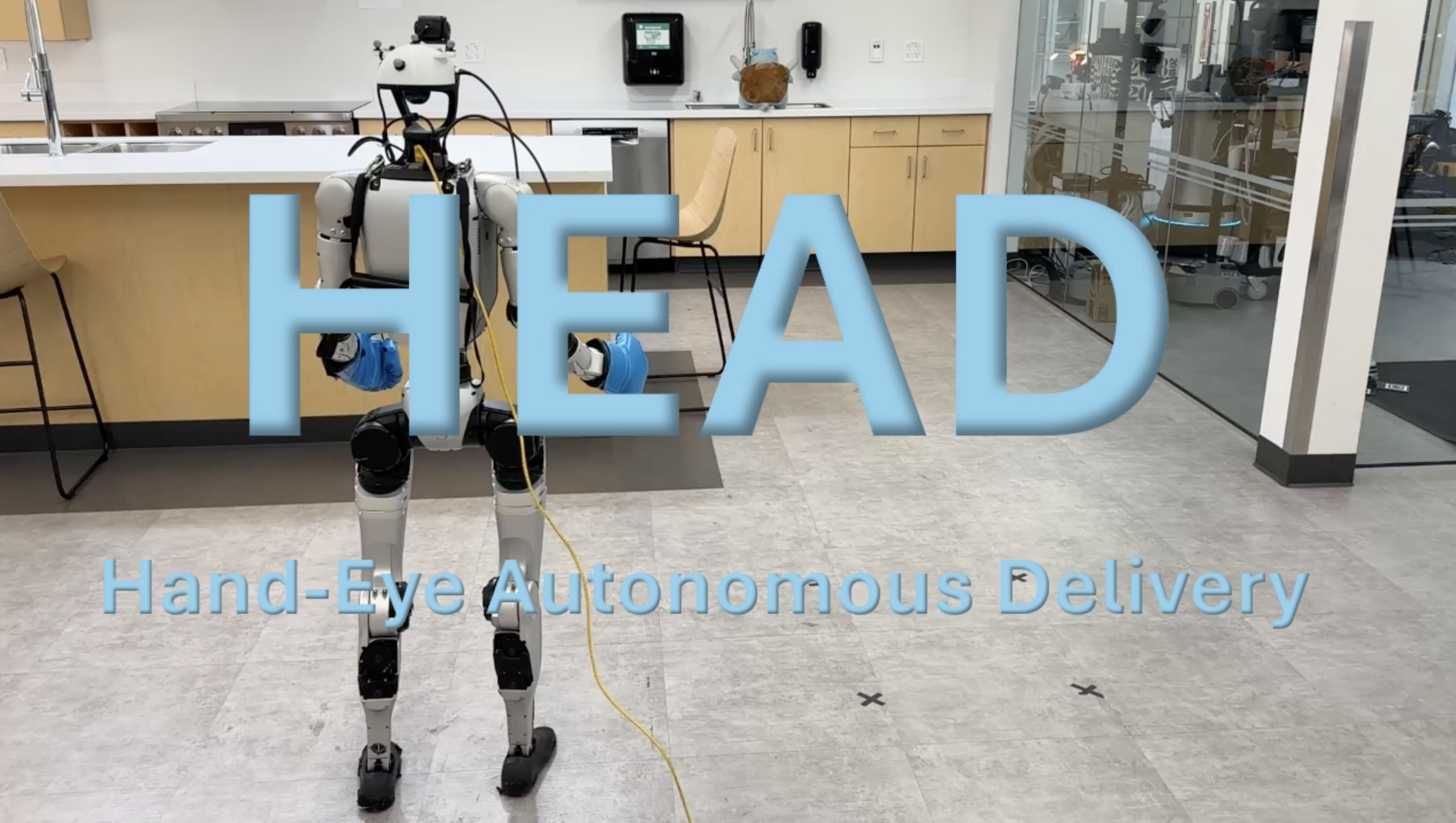

ヒューマノイドが人の動作と視覚情報をもとに「目で見て手を動かす」動作を学べる新技術「HEAD」が、スタンフォード大学の研究チームから公開されました。

スタンフォード大学の研究チームが発表したHEADは、人間のモーションと視覚認知データを活用し、ヒューマノイドがナビゲーション、歩行(ロコモーション)、および目と手の動作(リーチング)を同時に学習できる新たなフレームワークです。この仕組みでは、高レベルな計画者(プランナー)が手や目の到達位置・方向を指示し、低レベルな制御政策(ポリシー)が全身の動きを制御します。こうしたモジュラー設計により、複雑な動作を柔軟に学習させることが可能になります。

この技術は、サービス業や物流、自動化された診療・介護現場などで、より自然で人間に近い動作を実現するヒューマノイド開発に道を開く可能性があります。将来的には、ロボットが人の動きを観察し、自らの手と目で操作を行うような場面で、HEADの導入が進むことが期待されます。

Hand-Eye Autonomous Delivery: Learning Humanoid Navigation, Locomotion and Reaching

Paper description.