ARヘッドセットと人工知能を組み合わせることで、視線だけでロボットアームを制御できるシステムが開発された。重度の運動障害を持つ人々が、物理的な入力デバイスを使わずに身の回りの物を操作できるようになる。

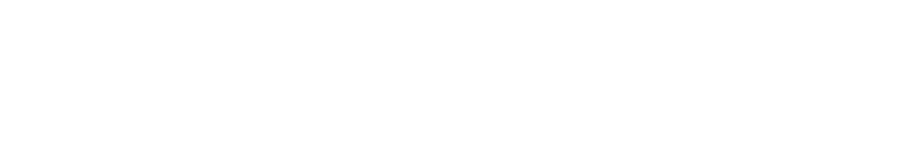

韓国の研究チームが開発したこのシステムは、Microsoft HoloLens2のAR技術と、物体検出AI「YOLOv8」を統合している。利用者が飲み物などの対象物を5秒間見つめるだけで、ロボットアームが自動的にそれを把握し、口元まで運ぶことができる。

従来の支援技術では、ジョイスティックなどの物理的な操作が必要だったが、重度の運動障害を持つ人にとっては使用が困難だった。音声コマンドと組み合わせるシステムも存在したが、設定が複雑で実用性に課題があった。

実験では、1メートル以内の距離にある物体に対して100%の把握成功率を達成した。深度センサーの精度の関係で、1メートルを超えると成功率は約60%に低下するものの、日常生活の多くの場面で十分な性能を発揮する。

この技術は、介護現場における人手不足の緩和にも貢献する可能性がある。介護スタッフの身体的負担を軽減し、より質の高いケアの提供につながることが期待される。

さらに、将来的には家庭用サービスロボットへの応用も視野に入る。高齢者の一人暮らしが増加する中、視線だけで操作できるロボットは生活支援の新たな選択肢となるだろう。障害の有無にかかわらず、誰もが使いやすいインターフェースとして、ロボティクス産業全体の発展にも寄与すると考えられる。